Artículo de fraude

La Ley de IA de la Unión Europea: Introducción a la primera regulación sobre inteligencia artificial

El uso de la inteligencia artificial en la Unión Europea (UE) será regulado por la Ley de IA de la UE, la primera ley integral de IA en el mundo. Descubra cómo funciona.

Explicación de la Ley de Inteligencia Artificial de la Unión Europea

Los avances en tecnología e inteligencia artificial (IA) han levantado la necesidad de una regulación protectora para prevenir riesgos y resultados perjudiciales para las poblaciones de todo el mundo. Un lugar donde estas reglas han tomado forma es Europa. En abril de 2021, la Comisión de la Unión Europea propuso el primer marco integral para regular el uso de la IA. La prioridad de la UE es garantizar que los sistemas de IA utilizados en la UE sean seguros, transparentes, trazables, no discriminatorios y amigables con el medio ambiente.

En Veriff, estamos desarrollando constantemente nuestras soluciones de identificación biométrica. Usamos IA y aprendizaje automático para hacer que nuestro proceso de identificación sea más rápido, seguro y mejor. Operamos a nivel global y nuestros equipos legales monitorean continuamente los diversos paisajes legales locales, por lo que estamos perfectamente posicionados para navegar estas regulaciones.

1. ¿Qué es la Ley de IA de la UE?

La Ley de IA es una ley europea sobre inteligencia artificial (IA): la primera por una gran potencia económica a nivel mundial.

Fue propuesta por la Comisión de la UE en abril de 2021.

Al igual que el Reglamento General de Protección de Datos de la UE (GDPR) de 2018, la Ley de IA de la UE podría convertirse en un estándar global, determinando hasta qué punto la IA tiene un efecto positivo en lugar de negativo en su vida, donde quiera que esté. La regulación de IA de la UE ya está causando revuelo internacionalmente.

2. ¿La Ley de IA de la UE ya está adoptada y en vigor?

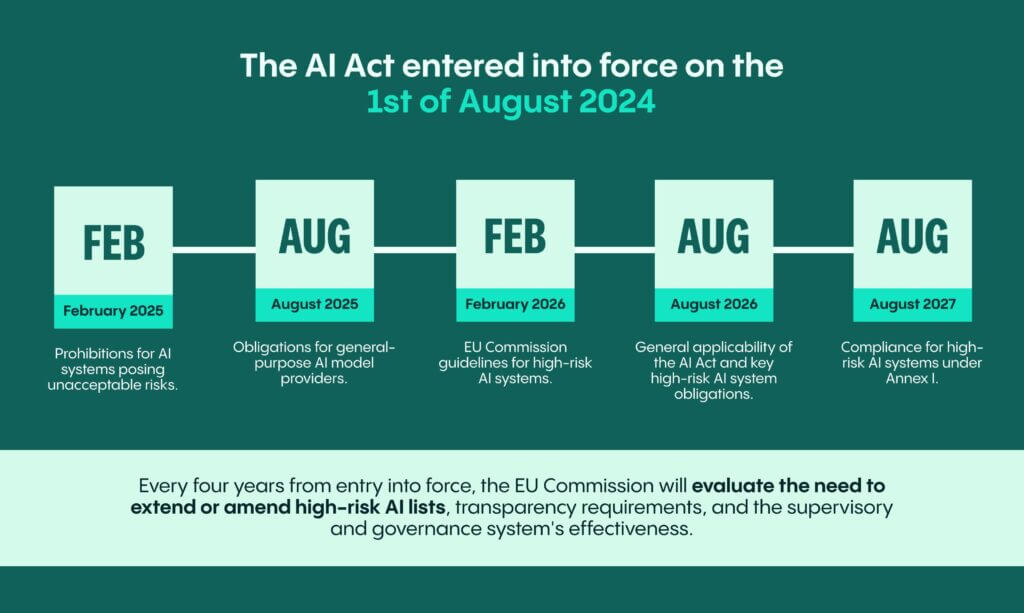

Sí, la Ley de IA entró en vigencia el 1 de agosto de 2024. Esto marca la cuenta regresiva para muchos otros hitos de la Ley de IA.

Para la mayoría de las empresas, estas son las fechas importantes a tener en cuenta:

- Para febrero de 2025, 6 meses después de la aplicación, se prohibirán los sistemas de IA que planteen riesgos inaceptables (denominados «sistemas de IA prohibidos»). Esto significa que para entonces, las empresas deberán comprender si los sistemas que proporcionan o utilizan calificarán como prohibidos y realizar los ajustes, según sea necesario.

- Para agosto de 2025, 12 meses después de la entrada en vigor, se aplican obligaciones para los proveedores de modelos de IA de uso general junto con la primera revisión anual de la Comisión de la UE sobre las listas de sistemas de IA prohibidos y de alto riesgo según el Anexo III de la Ley de IA. El Anexo III y el Anexo I son anexos clave de la Ley de IA sobre los cuales se basa la designación de sistemas de IA de alto riesgo.

- Para febrero de 2026, 18 meses después de la entrada en vigor, la Comisión de la UE deberá proporcionar directrices que especifiquen la implementación práctica para la clasificación de sistemas como de alto riesgo de IA. Este será un hito importante y, con suerte, aclarará múltiples áreas grises para muchas empresas.

- En agosto de 2026, 24 meses desde la entrada en vigor, la Ley de IA se vuelve aplicable en general junto con las principales obligaciones de los sistemas de IA de alto riesgo conectadas con el Anexo III de la Ley de IA. Es importante señalar que en caso de que un sistema haya sido puesto en servicio o en el mercado antes de agosto de 2026, las obligaciones relacionadas con los sistemas de IA de alto riesgo solo se aplican si desde agosto de 2026 esos sistemas están sujetos a cambios significativos en sus diseños.

- En agosto de 2027, 36 meses desde la entrada en vigor, los sistemas de IA de alto riesgo bajo el Anexo I necesitarán cumplir con las obligaciones derivadas de la Ley de IA.

La Ley de IA ahora incluye evaluaciones regulares para mantenerla relevante y actualizada. Ha introducido un sistema de evaluación periódico para asegurar su relevancia continua y actualizaciones. Cada cuatro años desde la entrada en vigor y posteriormente, la Comisión de la UE evaluará la necesidad de extender o añadir elementos a las listas de IA de alto riesgo, enmendar los requisitos de transparencia y revisar la efectividad del sistema de supervisión y gobernanza. La función de la Oficina de IA, el proceso de estandarización y los códigos de conducta voluntarios también serán evaluados.

3. ¿Cómo regulará la UE con la Ley de IA?

La Ley de IA se propone siguiendo estos objetivos:

- asegurar que los sistemas de IA que se coloquen en el mercado de la UE y se utilicen en la UE sean seguros y respeten las leyes existentes sobre derechos fundamentales y valores de la Unión;

- asegurar la certeza jurídica para facilitar la inversión y la innovación en IA;

- mejorar la gobernanza y la aplicación efectiva de la ley existente sobre derechos fundamentales y requisitos de seguridad aplicables a los sistemas de IA;

- facilitar el desarrollo de un mercado único para aplicaciones de IA legales, seguras y confiables y prevenir la fragmentación del mercado.

- La UE regulará los sistemas de IA según el nivel de riesgo que representen para la salud, la seguridad y los derechos fundamentales de una persona. Ese enfoque debería adaptar el tipo y el contenido de tales normas a la intensidad y el alcance de los riesgos (alto riesgo o riesgo mínimo) que los sistemas de IA pueden generar. La ley asigna aplicaciones de IA a tres categorías de riesgo.

- Primero, las aplicaciones y sistemas que crean un riesgo inaceptable, como la recolección de imágenes faciales de la internet sin objetivo específico o el uso de cámaras de seguridad para crear bases de datos de reconocimiento facial, la puntuación social administrada por el gobierno, sistemas de IA o aplicaciones que manipulan el comportamiento humano para eludir la voluntad libre de los usuarios, están prohibidos.

- Segundo, sistemas de IA de alto riesgo, potencialmente como sistemas para determinar el acceso a instituciones educativas o para reclutar personas, están sujetos a requisitos legales específicos y minuciosos, incluidos sistemas de mitigación de riesgos, conjuntos de datos de alta calidad, registro de actividades, documentación detallada, información clara para los usuarios, supervisión humana y un alto nivel de robustez, precisión y ciberseguridad.

- Las aplicaciones no prohibidas o no clasificadas como de alto riesgo están reguladas de forma ligera. Esos sistemas se llaman sistemas de riesgo mínimo, y esa sería una categoría en la que presumiblemente caería la gran mayoría de los sistemas de IA. El requisito clave aquí es la transparencia: en caso de que un sistema de IA esté diseñado para interactuar con una persona, se debe hacer saber que la persona está interactuando con un sistema de IA, a menos que sea claramente obvio que la interacción se está realizando con un sistema de IA. Además, los proveedores cuyos sistemas de IA generen o manipulen salidas en forma de contenido audiovisual y texto deberán tener las marcaciones respectivas.

- Se introduce un conjunto separado de reglas para modelos de IA de uso general.

En las secciones siguientes, examinaremos la regulación sobre sistemas de IA prohibidos, sistemas de IA de alto riesgo y modelos de IA de propósito general.

With a quick selfie our AI can estimate your age in less than a second!

Habla con uno de los expertos en fraude de Veriff para conocer cómo la IDV puede ayudar a tu empresa.

4. La Ley de IA contiene:

- Información sobre su alcance y definiciones aplicables para los participantes en el ciclo de vida y ecosistema de IA

- Establece sistemas de IA prohibidos

- Regula exhaustivamente los sistemas de IA de alto riesgo

- Medidas que apoyan la innovación (por ejemplo, «regulatory sandboxes»)

- Gobernanza e implementación de la Ley de IA y códigos de conducta

- Regulación sobre multas

5. ¿A quién se aplica la Ley de IA?

- Proveedores de sistemas de IA que coloquen en el mercado o pongan en servicio sistemas de IA en la UE, independientemente de si dichos proveedores están establecidos dentro de la UE o en un tercer país (por ejemplo, EE. UU.);

- Desplegadores de sistemas de IA ubicados dentro de la UE;

- Proveedores y usuarios de sistemas de IA que se encuentran en un tercer país, pero donde la salida producida por el sistema se utiliza en la UE o el sistema afecta a las personas en la UE.

6. ¿Cómo asegurar el cumplimiento con la Ley de IA?

Se recomienda monitorear de cerca los desarrollos en torno a la Ley de IA para mantenerse al día con toda la orientación relevante que se emitirá. Sin embargo, aquí hay algunos consejos para compartir:

- Recorre el texto: tu organización necesita identificar dónde se sitúa en la “cadena de valor” de la IA. Por ejemplo, ser proveedor o usuario de sistemas de IA le somete a posiblemente diferentes obligaciones. Esto necesitará estar acompañado de un mapeo de dónde su organización utiliza sistemas y modelos de IA.

- Después de completar el mapeo, recorre los sistemas para entender la designación de riesgos bajo la Ley de IA y las obligaciones relacionadas. Utilice ayuda técnica y legal externa, si es necesario.

- Trabaja con tus departamentos de Legal, Riesgo, Calidad, Ingeniería/Desarrollo de Productos para identificar los riesgos relacionados con el uso de IA en general.

- Habrá una creación extensa de normas técnicas y no técnicas respectivas, ya sea por las Organizaciones Europeas de Estandarización y/o por la Comisión Europea al involucrar a expertos. Vale la pena monitorear el trabajo en torno a eso. Ya existen algunas normas para entender ciertas obligaciones que conciernen a los productos identificados anteriormente como sistemas de IA de alto riesgo. Además, ya existen estándares sobre sistemas de gestión de calidad y gestión de riesgos. Proporcionan una línea base para lo que debe considerarse en caso de que caiga en la categoría de proveedor de IA de alto riesgo.;

7. Aplicación de la Ley de IA y sanciones

Las multas bajo la Ley de IA variarían desde 35 millones de euros o 7% de la facturación mundial anual (lo que sea mayor) por violaciones de aplicaciones de IA prohibidas, 15 millones de euros o 3% por violaciones de otras obligaciones, y 7.5 millones de euros o 1.5% por proporcionar información incorrecta. Se prevén multas más proporcionales para las pymes y startups en caso de infracciones de la Ley de IA.

With a quick selfie our AI can estimate your age in less than a second!

Habla con uno de los expertos en fraude de Veriff para conocer cómo la IDV puede ayudar a tu empresa.