Artigo sobre Fraude

A Lei de IA da União Europeia: Introdução à primeira regulamentação sobre inteligência artificial

O uso de inteligência artificial na União Europeia (UE) será regulamentado pela Lei de IA da UE, a primeira lei de IA abrangente do mundo. Descubra como funciona.

A Lei de Inteligência Artificial da União Europeia explicada

Avanços na tecnologia e na inteligência artificial (IA) aumentaram a necessidade de regulamentação protetiva para prevenir riscos e resultados prejudiciais para as populações em todo o mundo. Um lugar onde essas regras tomaram forma é na Europa. Em abril de 2021, a Comissão da União Europeia propôs o primeiro quadro abrangente para regular o uso da IA. A prioridade da UE é garantir que os sistemas de IA utilizados na UE sejam seguros, transparentes, rastreáveis, não discriminatórios e ambientalmente amigáveis.

Na Veriff, estamos constantemente desenvolvendo nossas soluções de identificação biométrica. Usamos IA e aprendizado de máquina para tornar nosso processo de identificação mais rápido, seguro e melhor. Operamos globalmente, e nossas equipes jurídicas monitoram continuamente as diversas paisagens legais locais, para que estejamos perfeitamente posicionados para navegar por essas regulamentações.

1. O que é a Lei de IA da UE?

A Lei de IA é uma legislação europeia sobre inteligência artificial (IA) – a primeira de uma grande potência econômica global.

Foi proposta pela Comissão da UE em abril de 2021.

Assim como o Regulamento Geral sobre a Proteção de Dados da UE (GDPR) em 2018, a Lei de IA da UE pode se tornar um padrão global, determinando até que ponto a IA tem um efeito positivo em vez de negativo em sua vida, onde quer que você esteja. A regulamentação de IA da UE já está causando impacto internacionalmente.

2. A Lei de IA da UE já foi adotada e está em vigor?

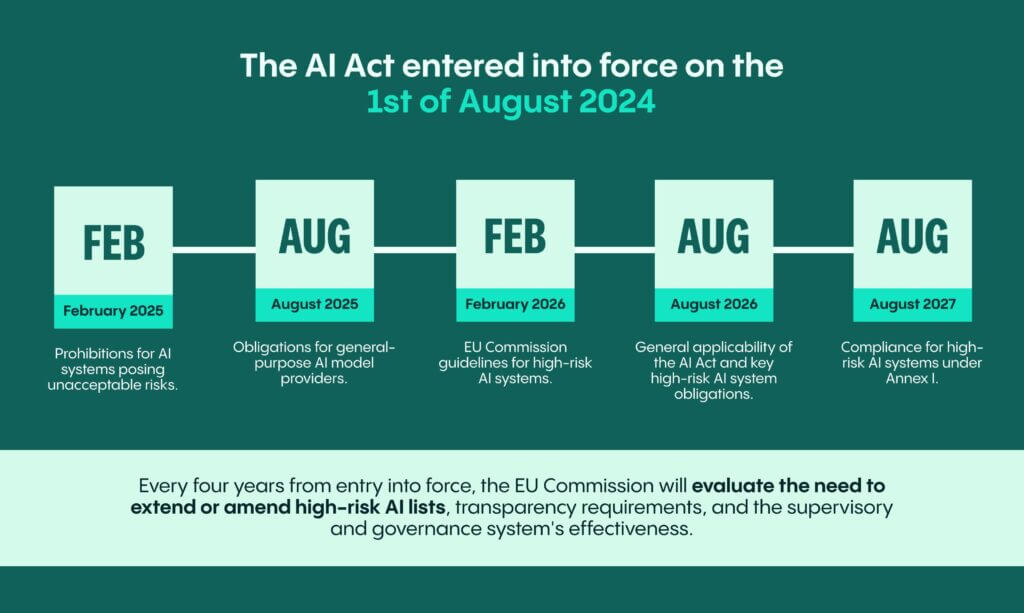

Sim, a Lei de IA entrou em vigor em 1º de agosto de 2024. Isso marca a contagem regressiva para muitos outros marcos da Lei de IA.

Para a maioria dos negócios, essas são as datas importantes a serem lembradas:

- Até fevereiro de 2025, 6 meses após a aplicação, as proibições para sistemas de IA que apresentam riscos inaceitáveis (referidos como “sistemas de IA proibidos”). Isso significa que, até essa data, as empresas precisarão entender se os sistemas que fornecem ou utilizam qualificam-se como proibidos e fazer ajustes, conforme necessário.

- Até agosto de 2025, 12 meses após a entrada em vigor, as obrigações para provedores de modelos de IA de finalidade geral se aplicam juntamente com a primeira revisão anual da Comissão da UE sobre as listas de sistemas de IA proibidos e sistemas de IA de alto risco sob o Anexo III da Lei de IA. Os Anexos III e I são anexos-chave da Lei de IA com base nos quais a designação de sistema de IA de alto risco é construída.

- Até fevereiro de 2026, 18 meses após a entrada em vigor, a Comissão da UE deve fornecer diretrizes especificando a implementação prática para a classificação de sistemas como sistemas de IA de alto risco. Este será um marco importante e esperamos que esclareça diversas áreas cinzentas para muitos negócios.

- Em agosto de 2026, 24 meses após a entrada em vigor, a Lei de IA se torna aplicável em geral juntamente com as principais obrigações de sistemas de IA de alto risco relacionadas ao Anexo III da Lei de IA. É importante notar que, caso um sistema tenha sido colocado em operação ou no mercado antes de agosto de 2026, então as obrigações relacionadas aos sistemas de IA de alto risco se aplicam apenas se, a partir de agosto de 2026, esses sistemas estiverem sujeitos a mudanças significativas em seus projetos.

- Em agosto de 2027, 36 meses após a entrada em vigor, os sistemas de IA de alto risco sob o Anexo I precisarão cumprir as obrigações derivadas da Lei de IA.

A Lei de IA agora inclui avaliações regulares para mantê-la relevante e atualizada. Foi introduzido um sistema de avaliação periódica para garantir a relevância e atualizações contínuas. A cada quatro anos a partir da entrada em vigor e a partir de então, a Comissão da UE avaliará a necessidade de estender ou adicionar itens às listas de IA de alto risco, alterar os requisitos de transparência e revisar a eficácia do sistema de supervisão e governança. A função do Escritório de IA, o processo de padronização e os códigos de conduta voluntários também serão avaliados.

3. Como a UE regulamentará com a Lei de IA?

A Lei de IA é proposta seguindo estes objetivos:

- garantir que os sistemas de IA colocados no mercado da UE e usados na UE sejam seguros e respeitem as leis existentes sobre direitos fundamentais e valores da União;

- garantir certeza jurídica para facilitar investimento e inovação em IA;

- aumentar a governança e a aplicação eficaz da legislação existente sobre direitos fundamentais e requisitos de segurança aplicáveis aos sistemas de IA;

- facilitar o desenvolvimento de um mercado único para aplicações de IA legais, seguras e confiáveis e prevenir a fragmentação do mercado.

- A UE regulará os sistemas de IA com base no nível de risco que representam para a saúde, segurança e direitos fundamentais de uma pessoa. Essa abordagem deve adaptar o tipo e o conteúdo dessas regras à intensidade e ao escopo dos riscos (alto risco ou risco mínimo) que os sistemas de IA podem gerar. A legislação atribui aplicações de IA a três categorias de risco.

- Primeiro, aplicações e sistemas que criam um risco inaceitável, como coleta não direcionada de imagens faciais da internet ou gravações de CCTV para criar bancos de dados de reconhecimento facial, pontuação social gerida pelo governo, sistemas de IA ou aplicações que manipulam o comportamento humano para contornar a livre vontade dos usuários, são proibidos.

- Em segundo lugar, sistemas de IA de alto risco, potencialmente como sistemas que determinam o acesso a instituições educacionais ou para recrutamento de pessoas, estão sujeitos a requisitos legais específicos e rigorosos, incluindo sistemas de mitigação de riscos, conjuntos de dados de alta qualidade, registro de atividades, documentação detalhada, informações claras para usuários, supervisão humana e um alto nível de robustez, precisão e cibersegurança.

- Aplicações não explicitamente proibidas ou listadas como de alto risco são regulamentadas de forma leve. Esses sistemas são chamados de sistemas de risco mínimo, e presumivelmente a vasta maioria dos sistemas de IA se enquadraria nessa categoria. O requisito principal aqui é a transparência – caso um sistema de IA seja projetado para interagir com uma pessoa, deve ser informado que a pessoa está interagindo com um sistema de IA, a menos que seja evidentemente óbvio que a interação está sendo feita com um sistema de IA. Além disso, os provedores cujos sistemas de IA geram ou manipulam saídas na forma de conteúdo audiovisual e texto devem ter as respectivas marcações.

- Um conjunto separado de regras é introduzido para modelos de IA de propósito geral.

Nas próximas seções, examinaremos a regulamentação em torno de sistemas de IA proibidos, sistemas de IA de alto risco e modelos de IA de uso geral.

Fale conosco

Converse com um especialista em fraudes da Veriff para saber como IDV pode ajudar o seu negócio.

4. A Lei de IA contém:

- Informações sobre seu escopo e definições aplicáveis para participantes no ciclo de vida e ecossistema da IA

- Estabelece sistemas de IA proibidos

- Regula sistemas de IA de alto risco de forma rigorosa

- Medidas que apoiam a inovação (por exemplo, ambientes regulatórios de teste)

- Governança e implementação da Lei de IA e códigos de conduta

- Regulamentação sobre multas

5. A quem se aplica a Lei de IA?

- Provedores de sistemas de IA que colocam no mercado ou colocam em operação sistemas de IA na UE, independentemente de onde esses provedores estejam estabelecidos, na UE ou em um país terceiro (por exemplo, EUA);

- Fornecedores de sistemas de IA localizados dentro da UE;

- Provedores e usuários de sistemas de IA localizados em um país terceiro, mas onde a saída produzida pelo sistema é usada na UE ou o sistema afeta pessoas na UE.

6. Como garantir conformidade com a Lei de IA?

É aconselhável monitorar de perto os desenvolvimentos em torno da Lei de IA para se manter atualizado com todas as orientações relevantes que serão emitidas. No entanto, aqui estão algumas dicas para compartilhar:

- Trabalhe seu caminho através do texto – sua organização precisa identificar onde na cadeia de valor de IA sua organização se encontra. Por exemplo, ser um provedor ou um usuário de sistemas de IA pode sujeitá-lo a obrigações potencialmente diferentes. Isso precisará ser acompanhado do mapeamento de onde sua organização utiliza sistemas e modelos de IA.

- Depois de completar o mapeamento, trabalhe seu caminho através dos sistemas para entender a designação de risco sob a Lei de IA e as obrigações conectadas a ela. Utilize ajuda técnica e legal externa, se necessário.

- Trabalhe com seus departamentos jurídico, de risco, qualidade e de desenvolvimento de engenharia/produto para identificar riscos em torno do uso de IA em geral.

- Haverá uma criação extensa de normas técnicas e não técnicas respectivas – seja pelas organizações de padronização europeias e/ou pela Comissão Europeia, envolvendo especialistas. O trabalho em torno disso vale a pena ser monitorado. Já existem alguns padrões para entender certas obrigações que concernem os produtos identificados anteriormente como sistemas de IA de alto risco. Além disso, já existem padrões em relação a sistemas de gestão de qualidade e gestão de riscos. Eles fornecem uma base para o que deve ser considerado caso você se encaixe na categoria de provedor de IA de alto risco.;

7. Aplicação e penalidades da Lei de IA

As multas sob a Lei de IA variariam de €35 milhões ou 7% do faturamento global anual (o que for maior) para violações de aplicações de IA proibidas, €15 milhões ou 3% para violações de outras obrigações, e €7,5 milhões ou 1,5% por fornecer informações incorretas. Multas mais proporcionais são previstas para PMEs e startups em caso de infrações à Lei de IA.

Fale conosco

Converse com um especialista em fraudes da Veriff para saber como IDV pode ajudar o seu negócio.